Deepseek-R1-Ollama 调用方式

注:当前镜像仅支持本地访问,如需对外访问,推荐选择使用Vllm框架。

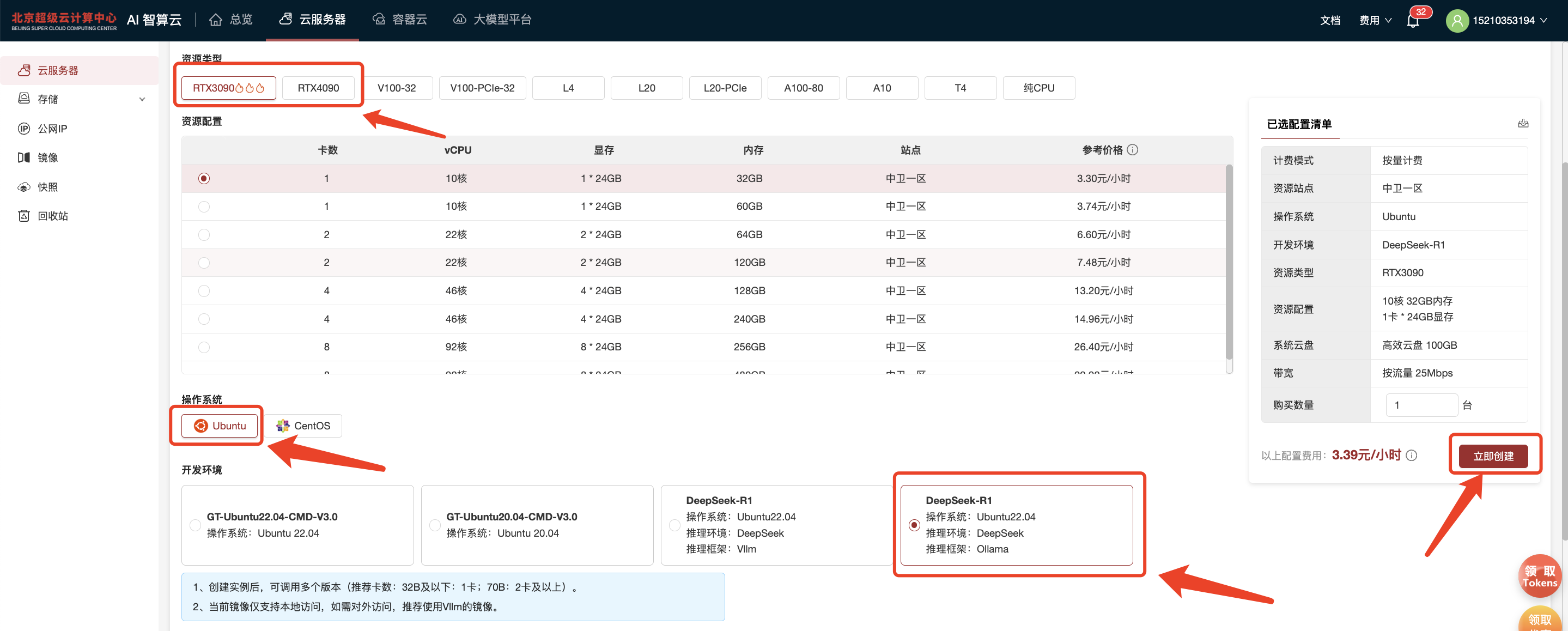

一、创建资源

3090、4090资源已部署DeepSeek R1镜像,支持命令行与Web可视化方式运行。

选择创建云服务器 -> 选中图中镜像,配置云盘与带宽等参数 -> 创建资源。

具体配置选择可以根据需求创建,请参考:AI 智算云产品文档中心_创建云服务器

二、运行

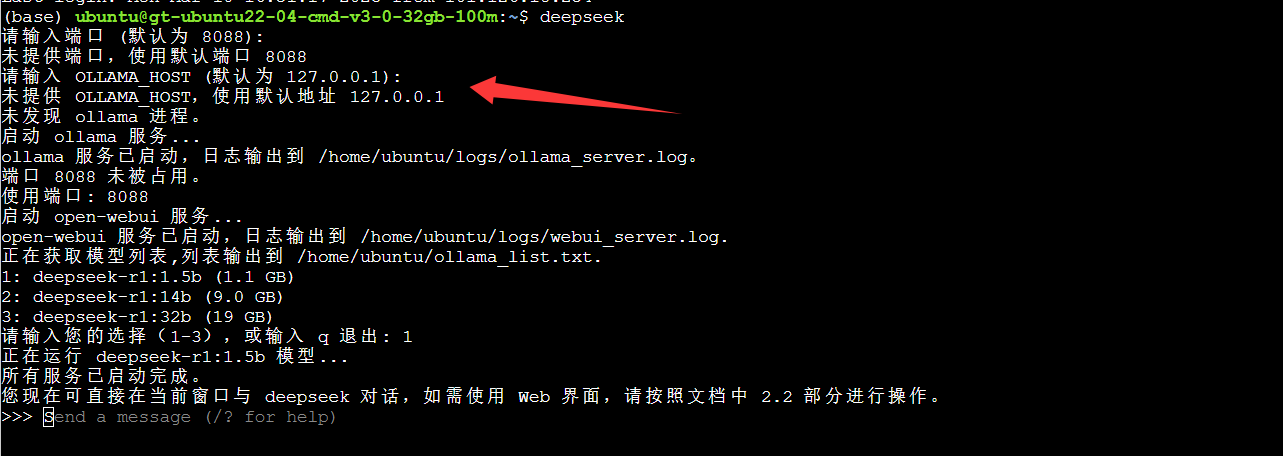

2.1 命令行方式

云服务器部署了多个模型库,可根据需求自行选择。

(1)执行命令deepseek

deepseek(2)根据提示,输入对应的数字,选择需要的模型,即可开启与DeepSeek对话,如下图所示:

测试参考:deepseek-r1:14b

注意事项:

(1)脚本存放在家目录下,即:/home/ubuntu 路径下,名为: run_ds.sh,请勿删除。

(2)使用交互式方式进行选择模型、设置端口等参数;若需要修改相关参数,请自行输入即可。

(3)如需自定义模型库,则修改脚本 run_ds.sh 中如下参数:

export OLLAMA_MODELS=/home/ubuntu/.ollama/models修改为

export OLLAMA_MODELS="自定义模型库绝对路径" 2.2 Web可视化方式运行

2.2.1 启动步骤

(1)按照2.1步骤启动服务。

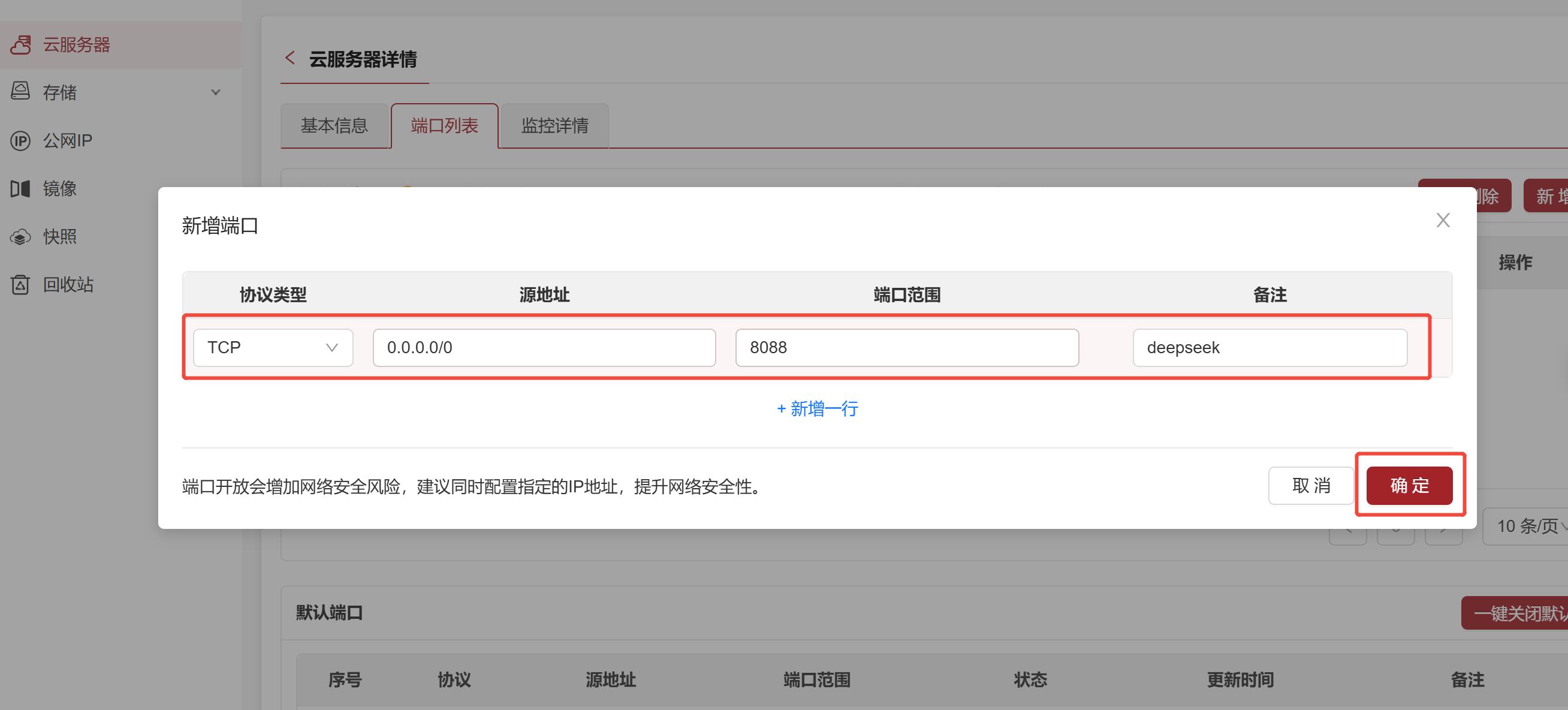

(2)点击云服务器ID:

(3)新增自定义端口:

(4)设置地址与端口:

源地址:0.0.0.0/0,端口范围:8088(或者自定义端口)。

(5)回到云服务器界面,复制外网IP。

(6)打开本地浏览器,输入“IP地址:端口号”如“xx.xxx.xxx.xxx:8088”(若自定义端口则输入:“xx.xxx.xxx.xxx:自定义端口”)。

注:首次登录需要先注册管理员账号。

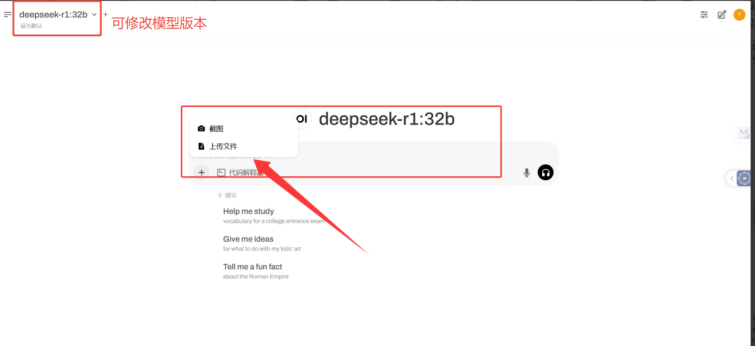

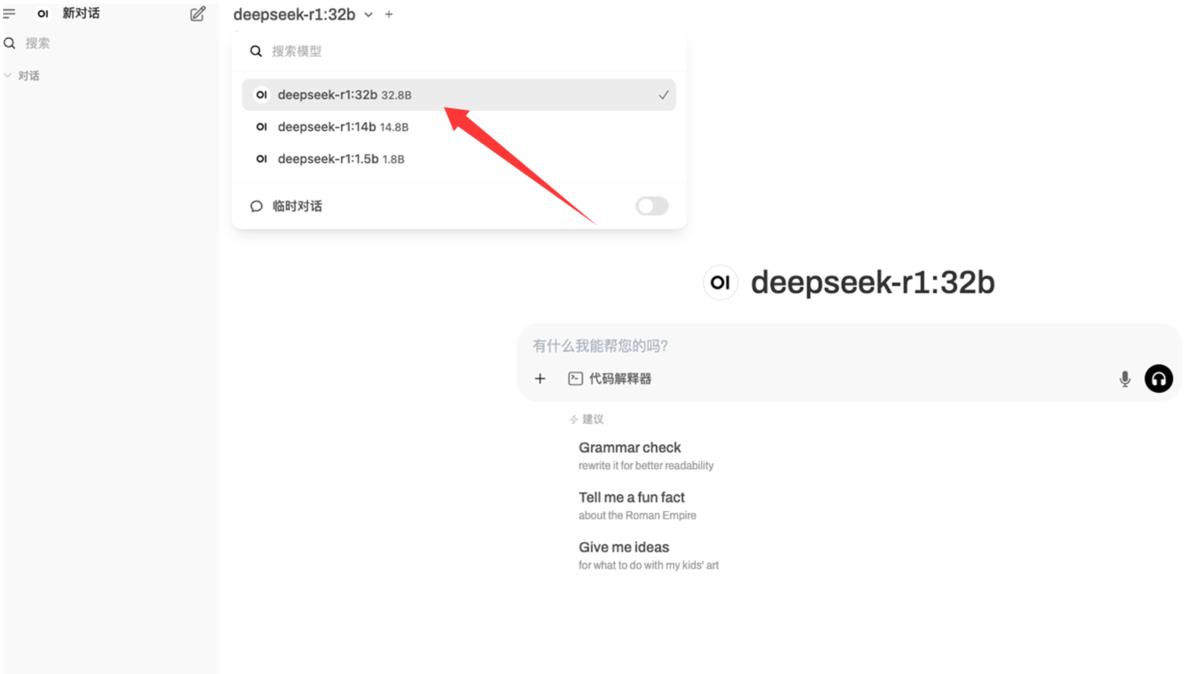

默认web界面为中文,默认模型参数为32b

登录管理员账号后,根据自行选择,设置新用户注册,具体流程如下:

(7)开启与DeepSeek对话。

2.2.2 账号设置(选做)

(1)开通注册账号功能

建议关闭新账号注册,普通用户由管理员账号统一分配设置;如若开启可以自行设置开启即可。

选择管理员设置—开启这个选项

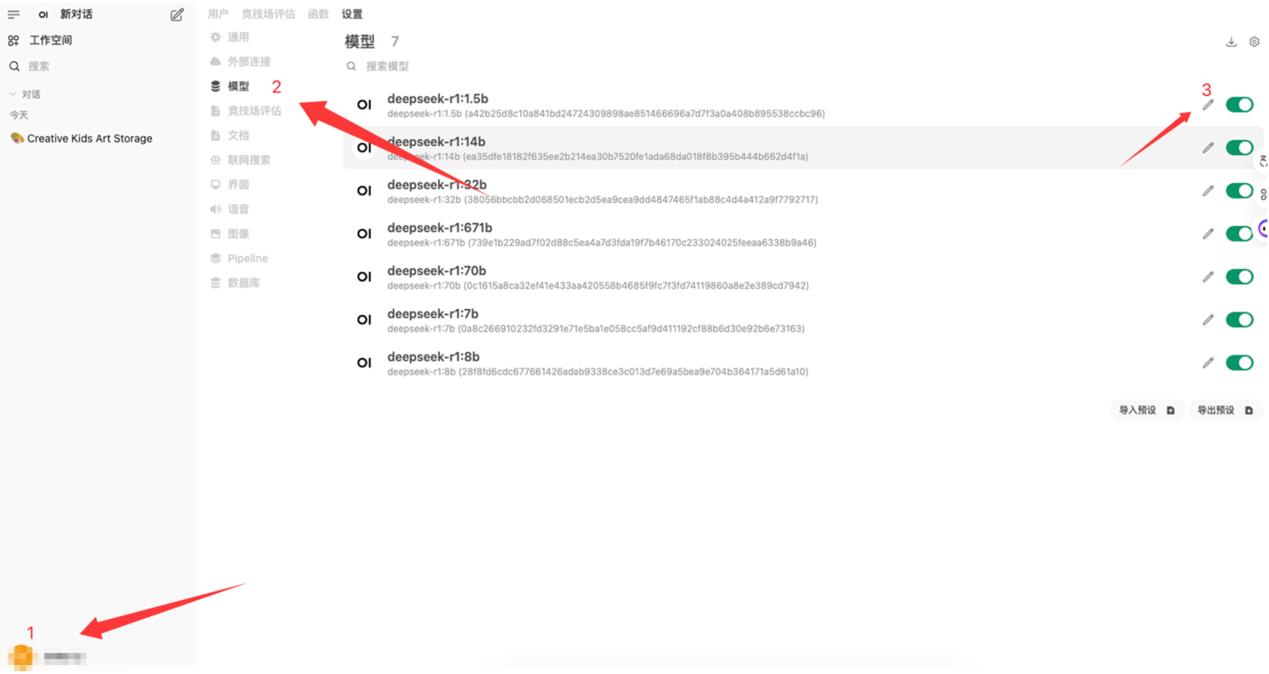

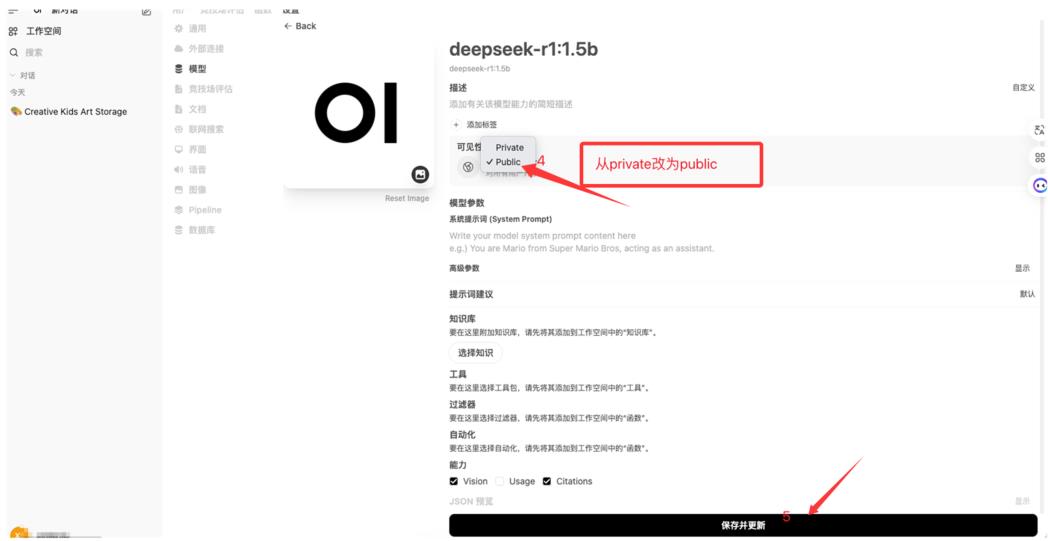

(2)普通用户加载模型

设置普通账号默认获取模型方式,需要在管理员控制板界面设置

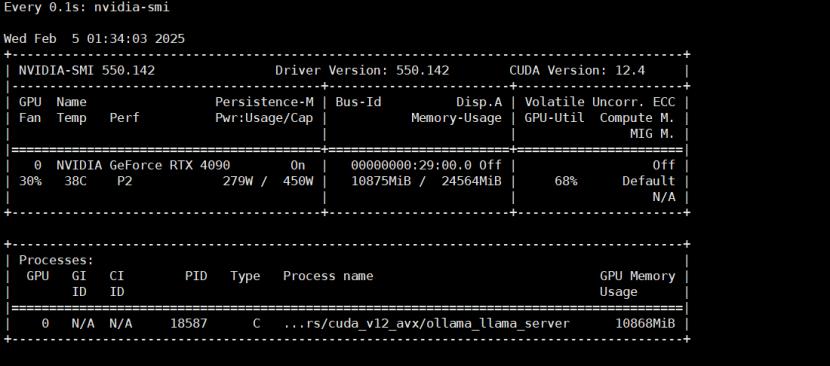

(3)查看GPU使用率情况